RAID5 vergrößert

Heute habe ich mein RAID5 mal wieder vergrößert. Ich hatte bislang meine 2 500GB WD Platten auf meinem File-Server als Software RAID5 laufen. Jetzt kann man sich natürlich fragen: „wie geht den das“? Für ein RAID5 braucht man mindestens 3 Platten. Das stimmt auch soweit aber nicht wenn man die dritte Platte als Spare-Laufwerk einbindet. Das ist ähnlich dem Hot-Spare-Laufwerk nur das es im Gegenzug nicht vorhanden ist. Da ich aber schon wusste das ich das RAID eines Tages (heute) vergrößern wollte, habe ich ein RAID5 gewählt. Man hätte auch die beiden als RAID0 einbinden können. Dann hätte ich mir 1TB Platten holen können um da wiederum dann ein RAID5 zu legen aber auf den Mischmasch wollte ich verzichten.

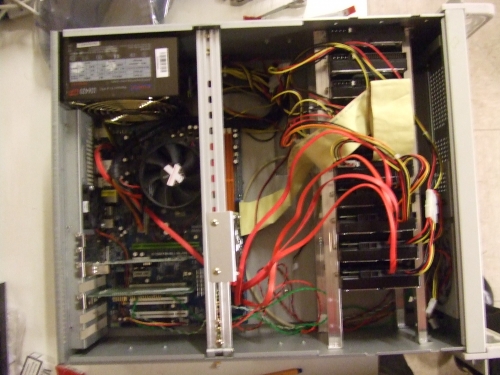

Da ich noch ein 4HE Gehäuse hatte und der Server eh im NWR steht, habe ich mir zum einbauen der Platten, 4 Winkel mit je 12 Löschern, machen lassen und sie angeordnet wie in Sun(s) X4540. Mein sind zwar nicht ganz so gut angeordnet aber theoretisch bekomme ich so 2x 12 Platten unter.

4x WD5000AACS (Energie effizient)

2x WD2500JB (System)

4x WD1200JB Für RAID vorgemerkt.

Jetzt habe ich auf jeden fall 4x 500GB. + System Platten. Zukünftig brauch ich aber noch einen IDE Controller der zumindest JBOD kann. Das RAID mach ich ja dann eh softwaretechnisch.

Hier noch wie ich das RAID vergrößert habe:

mdadm --add /dev/md0 /dev/sdc1

mdadm --add /dev/md0 /dev/sdd1

Mit watch cat /proc/mdstat mann man sich dann anschauen wie weit er ist.

Personalities : [linear] [multipath] [raid0] [raid1] [raid6] [raid5] [raid4] [raid10]

md0 : active raid5 sdd1[3](S) sdc1[4] sda1[0] sdb1[1]

976767872 blocks level 5, 64k chunk, algorithm 2 [3/2] [UU_]

[========>............] recovery = 42.0% (205538560/488383936) finish=55.3min speed=131587K/sec

unused devices:

Dann das RAID noch um die 4te Platte ergänzen.

mdadm --grow --raid-devices=4 /dev/md0

Mit watch cat /proc/mdstat kann man sich dann wieder anschauen wie weit er ist.

Personalities : [linear] [multipath] [raid0] [raid1] [raid6] [raid5] [raid4] [raid10]

md0 : active raid5 sdd1[3] sdc1[2] sda1[0] sdb1[1]

976767872 blocks super 0.91 level 5, 64k chunk, algorithm 2 [4/4] [UUUU]

[========>............] reshape = 40.3% (196861568/488383936) finish=2234.7min speed=2171K/sec

unused devices:

Ich hätte –raid-devices auch auf 5 stellen können um wieder eine als Spare-Laufwerk einzubinden. Aber das kann ich auch immer noch machen wenn der Platz wieder eng wird und ich auf Ausfallsicherheit verzichten kann.

Damit beim nächsten Starten des Systems das RaidArray auch wieder gefunden wird muss man noch folgendes unternehmen.

cd /etc/mdadm

echo 'DEVICE /dev/hd*[0-9] /dev/sd*[0-9]' > mdadm.conf

mdadm --detail --scan >> mdadm.conf

Ganz zum Schluss noch das ext3 vergrößern.

resize2fs /dev/md0

Tags: mdadm